Evolving Artificial Neural Networks

链接:https://sci2s.ugr.es/keel/pdf/algorithm/articulo/yao1999.pdf

日期:1999年

这是一篇类似于综述的文章,详细讲述了EA与ANN的结合,提出了使用EA去学习模型结构、学习机制等基本想法。

I. INTRODUCTION

略

II. THE EVOLUTION OF CONNECTION WEIGHTS

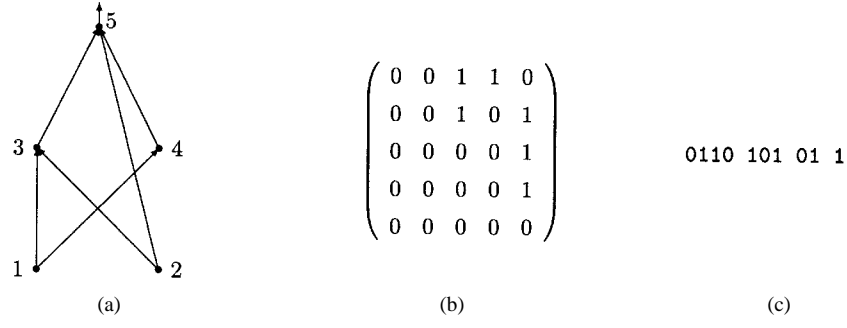

A. Binary Representation

就是对于一个固定的网络架构,把每一层的权重依次排列在一起,并且使用二进制去表示,然后使用GA去进行进化。

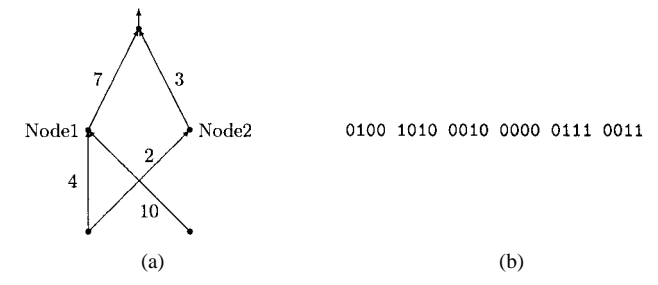

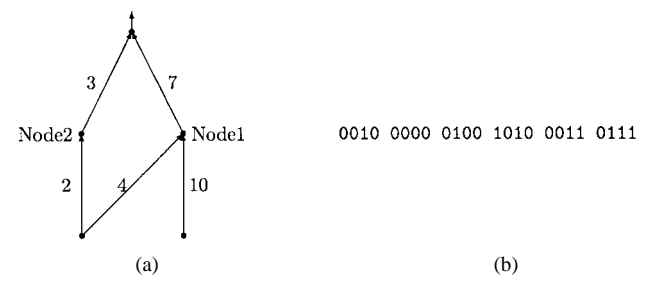

值得一提的是文中提到了competing convention problem,也就是两个神经网络实际上是等效的,但是排列方式不同,导致crossover比较难实现。比如以上两个完全相同的网络,对应的chromosomes却不同。

B. Real-Number Representation

不用二进制表示权重,而是用实数去表示权重,这种方法不能直接使用GA,但是可以使用ES, EP。大概策略都是给现有的权重加上高斯噪声,并且加上的噪声幅度逐渐减小。

C. Comparison Between Evolutionary Training and Gradient-Based Training

Evolutionary Training 擅长全局搜索,不依赖梯度,适用于不可微、多模态的误差曲面。

Gradient-Based Training 擅长局部微调,速度快,但易陷入局部最优。

D. Hybrid Training

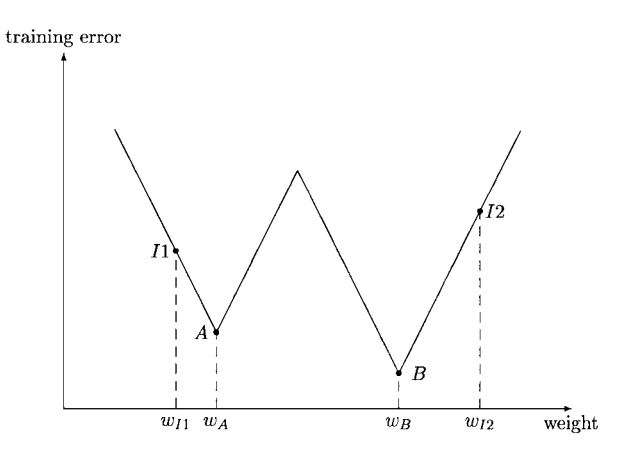

结合EA的全局搜索能力和局部搜索(如BP)的微调能力。使用EA寻找良好的初始权重区域(Basin of attraction),然后使用BP进行局部搜索以快速收敛到全局最优。

图 5. 使用EA寻找良好初始权重的示意图。$w_{I2}$ 是一个最佳初始权重,因为它可以通过局部搜索导致全局最优 $w_B$。

III. THE EVOLUTION OF ARCHITECTURES

A. The Direct Encoding Scheme

每个连接直接由二进制位指定。$N \times N$ 矩阵 $C = (c_{ij})$,其中 $c_{ij}=1$ 表示有连接,$0$ 表示无连接。

B. The Indirect Encoding Scheme

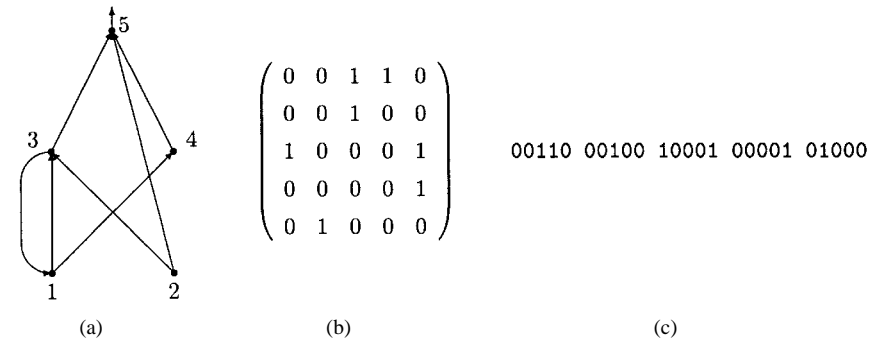

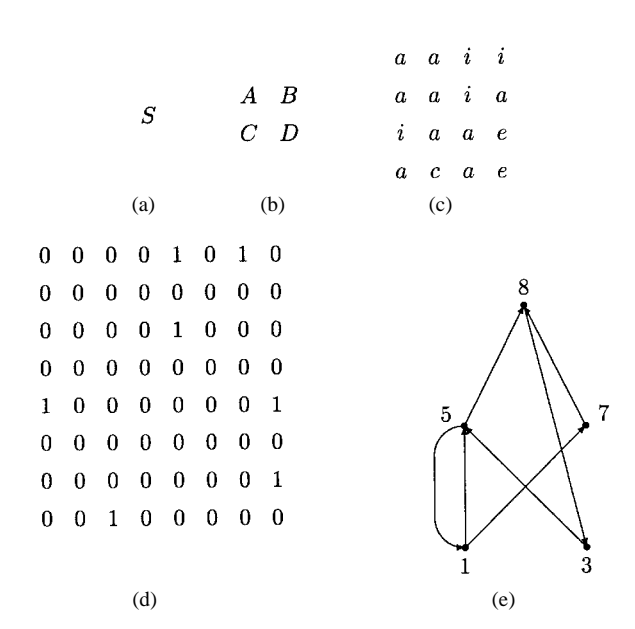

仅编码架构的一些特征,细节由通过发育规则或训练过程决定。

Developmental Rule Representation:编码用于构建架构的生成规则(如文法重写规则)。

$$S \longrightarrow \begin{pmatrix} A & B \\ C & D \end{pmatrix}$$

通过重复应用规则,直到矩阵中只包含终结符(0或1),从而生成连接矩阵。

这个过程类似于细胞分裂或分形几何的生成。

1. 初始状态:你只有一个符号 $S$,代表整个连接矩阵。

2. 第一步分裂:根据规则 $S \to \begin{pmatrix} A & B \\ C & D \end{pmatrix}$,$S$ 被替换为一个 $2 \times 2$ 的矩阵,矩阵里有四个子块 $A, B, C, D$。

3. 第二步分裂:对 $A, B, C, D$ 分别应用它们各自的规则(例如 $A \to \begin{pmatrix} a & a \\ a & a \end{pmatrix}$)。现在矩阵变成了 $4 \times 4$ 大小。

4. 递归进行:这个过程不断重复,直到矩阵里的所有元素都是“终结符”(即具体的数值 0 或 1,代表有无连接)。

5. 结果:最终生成了一个巨大的连接矩阵(比如 $16 \times 16$ 或更大),但这整个复杂的结构只需要几条简单的规则就能编码。这就像DNA不直接记录每根血管的位置,而是记录了血管生长的“规则”。

图 9 & 10. 使用发育规则构建连接矩阵的示例。从初始状态S开始,逐步替换非终结符,直到生成最终的连接矩阵。

C. The Evolution of Node Transfer Functions

除了拓扑结构,节点的传递函数(也就是激活函数如Sigmoid, Gaussian)也可以进化。这允许网络自动选择最佳的函数混合。

D. Simultaneous Evolution

将架构和权重一起进化

IV. THE EVOLUTION OF LEARNING RULES

A. The Evolution of Algorithm Parameters

进化BP算法的参数(如学习率、动量)。这是最简单的形式。

B. The Evolution of Learning Rules

进化权重更新规则本身。通常假设学习规则是局部变量及其乘积的线性函数:

$$\Delta w(t) = \sum_{k=1}^{n} \sum_{i_1, i_2, \dots, i_k=1}^{n} \left( \theta_{i_1 i_2 \dots i_k} \prod_{j=1}^{k} x_{i_j} (t-1) \right) \tag{4}$$

- $\Delta w(t)$:权重的变化量(即我们想求的学习规则)。

- $x$:局部变量。这些是神经元能“看到”的信息,例如:

- $x_1$: 输入信号 (Input activation)

- $x_2$: 输出信号 (Output activation)

- $x_3$: 目标信号 (Target output)

- $x_4$: 误差信号 (Error)

- $x_5$: 当前权重值 (Current weight)

- $\prod x_{i_j}$:交互项。代表这些变量的乘积组合。例如 $x_1 \cdot x_4$ 可能代表“输入 $\times$ 误差”(这是Hebbian学习或Delta规则的核心逻辑)。

- $\theta$:进化系数(基因)。这是EA真正进化的部分。

- 如果进化将某一项的系数 $\theta$ 设为 0,意味着该规则不使用这种变量组合。

- 如果进化将某一项的系数 $\theta$ 设为 1,意味着该规则强烈依赖这种变量组合。

举例:

假设进化最终找到了这样的系数:对应 $(x_{input} \cdot x_{error})$ 的 $\theta = 0.5$,其他所有 $\theta = 0$。

那么进化出的规则就是:$\Delta w = 0.5 \cdot x_{input} \cdot x_{error}$。这正是经典的 Delta 规则。

通过这种方式,EA可以在不知道具体数学推导的情况下,自动“发现”有效的学习算法。

V. OTHER COMBINATIONS OF ANNs AND EAs

A. The Evolution of Input Features

使用EA选择最佳的输入特征子集,以此进行降维和去噪。

B. ANN as Fitness Estimator

在昂贵的控制系统进化中,使用ANN来模拟系统并快速评估适应度,避免频繁运行真实系统。

C. Evolving ANN Ensembles

利用整个种群的信息(不仅仅是最佳个体)来构建ANN集成,以提高泛化能力。

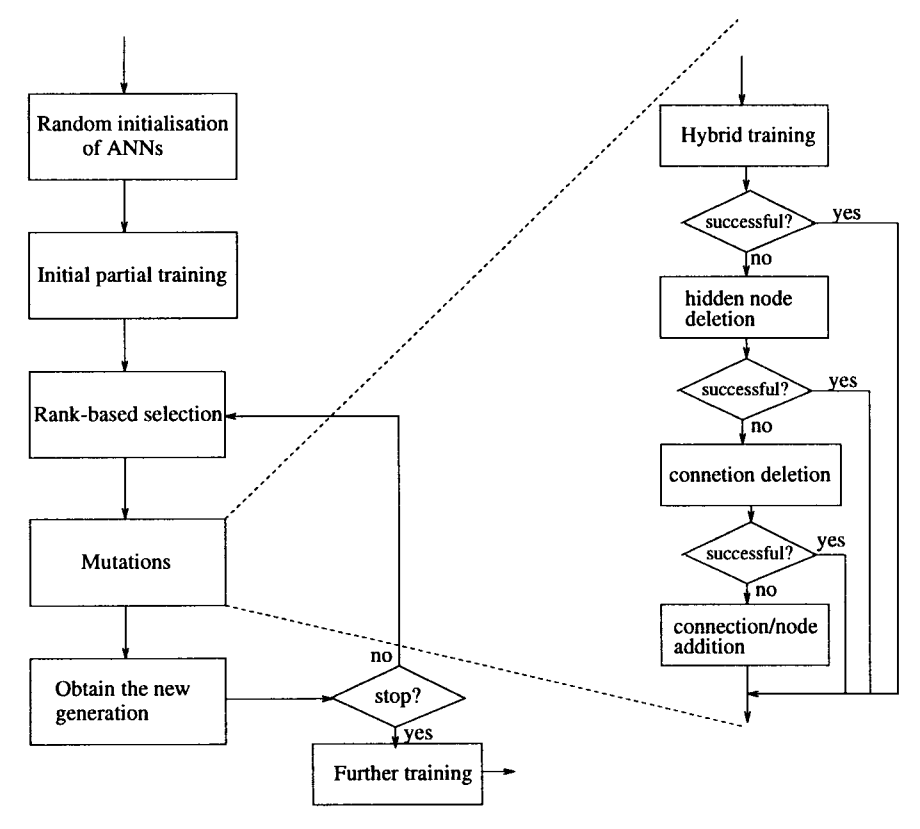

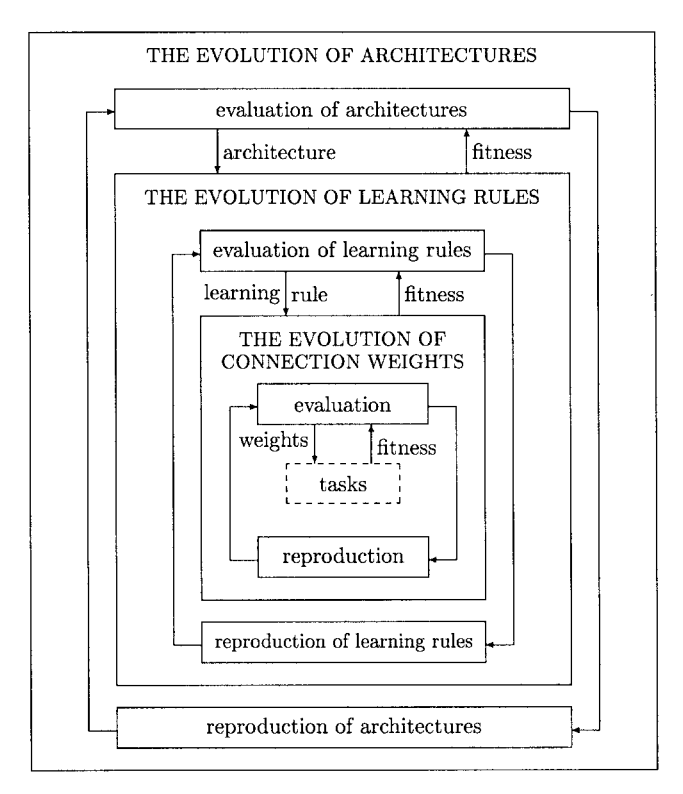

图 13. EANNs 的通用框架

三个层次:

- 连接权重进化:最底层,时间尺度最快。

- 架构进化:中间层。

- 学习规则进化:最高层,时间尺度最慢。

总结

- 权重进化:提供了全局训练方法。

- 架构进化:自动发现近优架构,避免人工试错。直接编码适合微调,间接编码适合特定类型。同步进化优于分离进化。

- 学习规则进化:赋予ANN适应环境变化的能力。

- 未来:随着并行计算能力的增强,大型ANN的进化将变得可行,并为模拟创造性过程提供了途径。